Udo Di Fabio war von 1999 bis 2011 Richter am Bundesverfassungsgericht in Karlsruhe. Der 63-Jährige gilt als liberal-konservativer Denker und ist einer der einflussreichsten Intellektuellen in Deutschland. Er beschäftigt sich immer wieder mit Problemen der Digitalisierung – wie etwa mit der Frage, ob die Urheber von Informationen im Internet anonym bleiben dürfen. Als Leiter der Ethik-Kommission zum automatisierten Fahren legte er außerdem im vergangenen Juni 20 Regeln vor, die den Rahmen für den Betrieb selbstfahrender Autos bilden sollen

Capital: Herr Di Fabio, ist der Einsatz künstlicher Intelligenz eine Revolution für den Menschen?

Udo Di Fabio: Das ist, als ob man fragen würde, ob der Auftritt des Homo sapiens in der Evolutionsgeschichte eine Revolution war. Wenn Intelligenz beginnt, sich aus den Bahnen der Programmierung zu lösen, kommt es zu Entwicklungssprüngen.

Warum?

Weil es einen Unterschied macht, ob man physische Fähigkeiten verbessert oder ob plötzlich das kognitive Moment hinzutritt. Bisher bedeutete Automatisierung: Der Mensch wird von physischen Bewegungen entlastet oder von einfachen Aufgaben wie Rechnen. Die Möglichkeit, assoziative Denkleistungen zu ersetzen, hatten wir bisher trotz aller Science-Fiction-Träume noch nicht.

Haben wir sie denn heute?

Nein, wenn man unter Denken assoziatives, selbstreflektiertes Denken versteht. Aber wir nähern uns schrittweise. Wir fangen an, kognitive Fähigkeiten zu ersetzen. Und zur gleichen Zeit entwickelt sich das Internet, das verstanden werden kann wie ein Netz für neuronale Bahnen der globalen Information. Das Netz in künftiger Verbindung mit künstlicher Intelligenz bedeutet wirklich einen Paradigmenwechsel. Es wälzt gesellschaftlich etwas um, und es wälzt Wertschöpfungsmodelle um.

Worin besteht diese Umwälzung?

Künstliche Intelligenz bedeutet ja, dass wir es mit einem selbstlernenden System zu tun haben. Wenn ein System fest programmiert ist, bleibt es auf dem Niveau eines Schachcomputers. Auch Schachmeister können ihn nicht schlagen, aber das hat mit Intelligenz nichts zu tun, sondern nur mit Rechenleistung. Das Besondere an künstlicher Intelligenz ist, dass sich die Programmierung plötzlich verflüssigt. Und das ähnelt dann schon dem echten Denken. Weil spontane Verbindungen möglich sind, die der Programmierer nicht vorausgesehen hat.

Das heißt, Maschinen werden dem Menschen ähnlicher? Müssten sie dann für ihre Handlungen nicht auch haften?

Wenn eine Technik kognitive Leistungen ersetzt oder simuliert, glaubt man rasch an Menschenähnlichkeit. Die Diskussion über eine neue Rechtspersönlichkeit für KI halte ich gelinde gesagt für sehr verfrüht, juristisch geradezu abwegig.

Was wäre das Problem?

Dann könnte man auch Haustieren eine Rechtspersönlichkeit zusprechen. Wir überschätzen die Technik. Es gibt eine Tendenz dazu, technische Artefakte zu humanisieren und etwas in ihnen zu sehen, was sie nicht sind. Wenn Sie einen Hund haben, der Sie treu anschaut und schon früh ahnt, dass Sie mit ihm Gassi gehen wollen, dann neigt man dazu, ihm menschliche Eigenschaften zuzubilligen. Aber der Hund denkt nie wie ein Mensch, er bleibt immer ein Hund. Wir sollten Technik nicht vermenschlichen, solange wir keinen Anlass dazu haben.

Und wer haftet, wenn mit der neuen Technik etwas schiefläuft?

Jemand, der ein Produkt mit künstlicher Intelligenz erzeugt, muss dafür die Haftung übernehmen. Der Gesetzgeber könnte sie ihm abnehmen und das Risiko vergesellschaften. Aber die Haftung würde nie auf die Maschine übergehen. Das wäre einer humanen Gesellschaft fremd, und es wäre auch nur eine Fiktion.

Sind sich die Unternehmen, die an diesen selbstlernenden Systemen arbeiten, denn im Klaren darüber, dass sie weiterhin haftbar sind für alles, was damit geschieht?

Mich sprach kürzlich ein Softwarehersteller an, der Mobilitätskonzepte mit künstlicher Intelligenz entwickelt. Er fragte mich überrascht, ob er wirklich für eine Technik haften müsse, die selbstlernend die von ihm vorgegebene Programmierung variiert. Er könne doch gar nicht wissen, wohin sich sein Produkt entwickelt. Aber wer etwas in den Verkehr bringt, der haftet auch für dieses Produkt. Es gibt keinen Hinterausgang, durch den Verantwortung auf Automaten und Roboter abgeschoben wird.

Aber gibt es nicht einen Moment, in dem die Maschine wirklich verantwortlich wird?

Nein. Es sei denn, wir erreichen irgendwann einen Punkt, an dem Rechenleistungen Assoziationsketten bilden, die selbstbewusstem Denken entsprechen. Das will ich nicht kategorisch für alle Zeit ausschließen, aber da sind wir noch nicht.

Wenn wir eines Tages an diesen Punkt kommen sollten, müssten wir dann nicht eine Grenze ziehen?

Möglicherweise ja, aber es muss nicht unbedingt ein kategorisches Verbot sein. Wenn eine neue Technik entsteht, sollte darüber diskutiert werden: Wie gestalten wir die Technik so, dass es eine humane Gesellschaft bleibt und dass wir darin glücklich werden?

Wer soll das gestalten?

Die Demokratien natürlich. In offenen Prozessen. Wir müssen darüber sprechen.

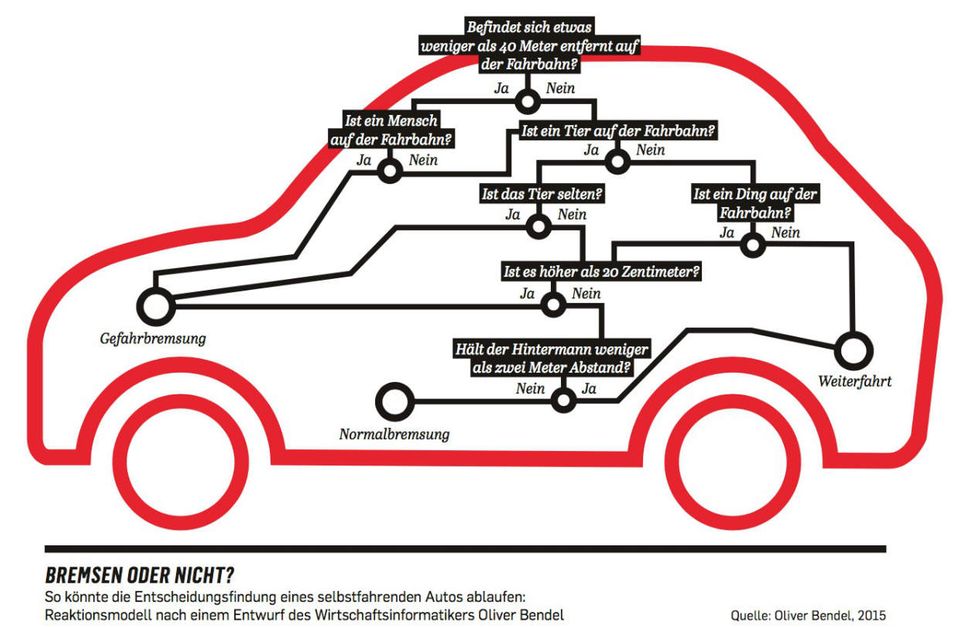

Wie weit reicht überhaupt unser Einfluss? Bald gibt es autonomes Fahren. Dann wird das Auto bei Unfällen eigenständige Entscheidungen treffen. Dabei wäre auch eine Opfer-Hierarchie denkbar, die automatisiert entscheidet, ob das Auto im Extremfall auf den alten Mann zusteuert oder auf die Frau mit dem Kinderwagen.

Niemand programmiert so etwas, das wäre auch unethisch. Es ist nie vertretbar zu sagen: Der ist alt, seine Restlebenserwartung ist gering, der kann überfahren werden. Allenfalls kann erwogen werden, ein Auto so zu programmieren, dass menschliche Schäden in Verletzungsintensität und Zahl zu mindern sind, wenn sie schon nicht vermieden werden können.

Ist das dann überhaupt noch künstliche Intelligenz? Dann gibt es ja einen Programmierer, der das Auto auf einen klar begrenzten Algorithmus festlegt.

Nicht jede Automatisierung und Vernetzung hat mit künstlicher Intelligenz zu tun, aber wir werden uns in diese Richtung entwickeln. Die Ethik-Kommission hält es für möglich, technische Grenzen zu formulieren, die auch von selbstlernenden Systemen nicht überschritten werden können. Schon heute lernen Versuchsautos aus Streckeninformationen. Dann lässt man sie Konsequenzen daraus ziehen – aber innerhalb einer bestimmten Bandbreite und indem man kontrolliert, was sich da entwickelt.

Was wäre das wichtigste Ziel für ein autonomes Auto?

Am Anfang steht die Aufgabe, Unfälle strikt zu vermeiden. Wenn sich das Lernen darauf konzentriert, dann geht es nicht um diese grausigen Auswahlentscheidungen „alter Mann oder Kind“, sondern darum, wie das System so agieren kann, dass es zu keinem Unfall kommt.

Unfälle werden sich auch mit Technik nicht immer vermeiden lassen.

Nicht vollständig, nein. Aber man wird zu Erfolgen kommen. Unsere Zeit mit Tausenden Verkehrstoten wird dann wie ein unglaublicher Anachronismus wirken. Hier darf man durchaus optimistisch sein.

Menschen, die vor künstlicher Intelligenz warnen, würden Ihnen antworten: Sie können ein Programm vielleicht mit Leitplanken starten lassen. Aber eventuell wird die Software das irgendwann für nicht effizient halten und die Regeln dann doch überschreiten.

Wir haben in der Ethik-Kommission gesagt, dass selbstlernende Systeme nicht jenseits unserer Regeln operieren dürfen. Sie brauchen also eine Programmierung, die eine Veränderung dieser Regeln nicht erlaubt. Wenn das – jenseits von immer möglichen Hackerangriffen – nicht garantiert werden kann, darf eine solche Technik nicht zugelassen werden. Wir müssen mit einer neuen Technologie Erfahrungen sammeln und dann vielleicht auch mal die Entscheidung treffen: Das machen wir nicht.

Brauchen wir einen großen roten Ausschalter für jede Art von KI?

Wir hatten in der Kommission auch solche Diskussionen und haben deshalb eine Dauerüberwachung der lernenden Software gefordert. Es muss eine unabhängige Stelle geben, die Daten und Szenarien sammelt und schaut, was das lernende System so macht. Wie die Flugsicherheit, die Unfälle auswertet. Natürlich würde der Chaos Computer Club sagen, dass man jeden Ausschaltknopf umgehen kann. Es ist eben immer ein Wettlauf zwischen Entwicklung und Missbrauch.

Das heißt, wir brauchen neue Gesetze. Kann das denn ein Land allein regeln?

Deutschland kann hier versuchen, kurzfristig Pionier zu sein, auch mit der Straßenverkehrsordnung. Aber die EU-Kommission arbeitet bereits an solchen Regeln, damit wird es zu einem europäischen Thema. Und letztlich haben wir einen Weltmarkt und wollen nicht für jede Region spezielle Fahrzeuge konstruieren. Also brauchen wir Normen und Absprachen untereinander. Es wird eine internationale Koordinierung geben müssen.

Beim autonomen Fahren kennen wir schon die möglichen rechtlichen Probleme. Aber bei KI gibt es ja noch ganz andere denkbare Fälle. Sollten wir da warten, bis die auftreten, oder brauchen wir eine internationale Charta, die zum Beispiel Kriegsroboter ausschließt?

Es gibt solche Bemühungen schon. Allerdings muss uns klar sein, dass es große Unterschiede in der Wahrnehmung gibt – zum Beispiel zwischen den USA und Europa.

Worin bestehen die?

Zum Beispiel darin, wie wir an neue technische Möglichkeiten herangehen. Wir sind in Deutschland nicht so innovationsfeindlich, wie wir uns manchmal selbst beschreiben, sonst wäre das Land wirtschaftlich nicht so gut aufgestellt. Der Mittelstand zum Beispiel ist viel smarter unterwegs, als mitunter angenommen wird. Aber viele Bedenken sind tatsächlich typisch deutsch. Man könnte auch fragen: Wie können wir an der Spitze der Innovation stehen? Wie können wir möglichst große Weltmarktanteile erobern? In den USA macht man oft erst einmal. Wenn dann allerdings ein Unfall passiert wie mit den autonomen Funktionen beim Tesla, dann wird auch dort kritisch nachgefragt.

Hätte es einen solchen Unfall bei BMW gegeben, wäre das Thema automatisiertes Fahren tot gewesen. Dann hätten Sie Ihre Kommission vermutlich dicht machen können.

Das zeigt die unterschiedlichen Mentalitäten. Es gibt in dieser Tech-Welt ein anderes Denken, auch ökonomisch.

Inwiefern?

Normalerweise muss man jedes Unternehmen sukzessive über den Erfolg am Markt aufbauen. In der Digitalisierung sehen wir, dass mit Visionen unglaubliches Kapital eingesammelt wird. Zuerst wird eine Menge Geld generiert. Dann erst wird die Technologie entwickelt, teilweise Expertise in großem Stil eingekauft. Und nicht selten setzt man auf politische Trends oder befördert sie wie die Elektromobilität, um in der sich dadurch ergebenden Disruption einen Vorsprung vor etablierten schwerfälligen Unternehmen zu bekommen. Vieles ist knallharter Wettbewerb, der sich hinter Technikfassaden und Gemeinwohlrhetorik versteckt. Es lohnt sich, die Strategien der großen Akteure genauer zu beobachten.

Und was sehen Sie da?

Ich sitze häufiger auf solchen Foren, zusammen mit coolen Leuten, die das Hemd über der Hose haben und Turnschuhe tragen, im Stil, der einst von Steve Jobs kreiert wurde. Dabei fällt mir auf, dass es immer dasselbe Muster ist. In der Selbstdarstellung wollen viele gar keine Kapitalisten sein. Ein Start-up-Inhaber, der nach Risikokapital Ausschau hält, präsentiert dem Publikum seine Visionen von großen Weltraumreisen und technischen Revolutionen. Aber was da kommt, ist nur der Kapitalismus 4.0, der teilweise realwirtschaftliche Strukturen aufsaugt und nutzt. Die heute am stärksten kapitalisierten Unternehmen tun so, als kümmerten sie sich nicht um Rendite, sondern nur um einen technischen Fortschritt im Dienst des globalen Gemeinwohls.

Tun Sie das nicht auch?

Jeder, der mit Erwerbsabsicht ein nützliches Produkt herstellt, fördert das Gemeinwohl. Aber im Silicon Valley sehe ich bei allem Respekt für Pionierleistungen manchmal doch eine Diskrepanz zwischen Renditeabsicht und Gemeinwohlanspruch. Bei Tesla ist von Klimaschutz und Marsmissionen die Rede, und dann werden teure Autos auf der Basis von Handybatterien zu einem Zukunftsmodell. Ohne dass irgendjemand noch genau nach Ökobilanzen fragt. Nun kann man sagen, so läuft das Geschäft, aber warum kommt da eigentlich nicht die politische Linke mit ihrer kritischen Analyse?

Vielleicht, weil die neuen Kapitalisten die kulturellen Codes der Linken übernommen haben. Das ist nicht so leicht zu durchschauen.

Da ist was dran. Das ist schon eine raffinierte Strategie, sich an öffentliche Trends so geschickt anzudocken und auf der Welle der digitalen Verwandlung der Welt zu surfen. Ich wünschte, Europa hätte etwas mehr von diesem Selbstbewusstsein. Allerdings darf man auch nicht Opfer der Dynamik technischer Möglichkeiten werden, sonst bleiben ganz reale Lebensverhältnisse und das normative Grundgerüst einer freien Gesellschaft auf der Strecke.

Der Unmut und das Unbehagen, die es bei vielen ja gibt, sind also Reaktionen auf die technische Entwicklung, von der sich Teile der Gesellschaft überfordert fühlen?

Die Digitalisierung, die eine starke Veränderung der Wertschöpfungsmodelle bedeutet, erschwert es, Wohlstandsgewinne breit auf Arbeitende zu verteilen. Und mit der künstlichen Intelligenz wird dieser Effekt noch verstärkt. Es gibt bei aller Überzeichnung ja Gründe dafür, dass plötzlich über Steuern auf Maschinen nachgedacht wird. Weil wir sehen, dass man mit hochautomatisierten Maschinen fast ganz ohne Menschen Wohlstand erzeugen kann.

Weil nicht nur der einfache Arbeiter ersetzt wird, sondern auch der Mittelbau.

Ja, natürlich. Mit KI können Steuerberater, Rechtsanwälte oder Ärzte technisch ersetzt werden. Auch der Dienstleistungsbereich ist also nicht automatisierungsfest. Das hätte man vor 20 Jahren noch für Science-Fiction gehalten. Die Komplexität unserer Rechtsordnung ruft geradezu nach künstlicher Intelligenz. Das Steuerrecht ist ein gutes Beispiel. Welcher Gewerbetreibende kann denn seine eigene Steuererklärung wirklich in allen rechtlichen Konsequenzen überschauen?

In Sonntagsreden wird gern gesagt, man müsse die Menschen „mitnehmen“. Das ist bei der Entwicklung, die Sie gerade beschrieben haben, vermutlich besonders wichtig. Wie nimmt man die Menschen mit?

Als Verfassungsrechtler gehe ich von einem Leitbild sich selbst entfaltender Persönlichkeiten aus. Ich mag daher diese Vokabel des Mitnehmens nicht besonders. Ich werde nicht gern mitgenommen. Der Staat soll nicht darüber nachdenken, wie er mich zu irgendwelchen Zielen mitnehmen kann, sondern darüber, wie in der Fläche der Gesellschaft Chancen entstehen. Wie also kann bei zunehmender Fragmentierung eine chancengerechte Gesellschaft in Zukunft noch aussehen?

Roboter als Richter sollten wir nicht wollen

Udo Di Fabio

Eine beliebte Antwort ist das bedingungslose Grundeinkommen als Reaktion auf den technischen Wandel. Was halten Sie von dieser Strategie?

Ich halte das für einen Irrweg. Die Grundrechte beginnen nicht mit einem Versorgungsanspruch, sondern mit dem Recht auf freie Entfaltung der Persönlichkeit. Die Idee, dass Bürger durch ein bedingungsloses Grundeinkommen von den grundlegenden Alltagssorgen befreit werden und dann erst kreativ werden, trifft vielleicht für eine Minderheit dynamischer und schöpferischer Menschen zu. Aber der Mensch neigt auch zu einer gewissen Trägheit, und wir brauchen Herausforderungen, auch Zwänge. Deshalb würde ein solches bedingungsloses Grundeinkommen bei sehr vielen Menschen keine kreativen Potenziale freisetzen, sondern sie nur zu Versorgungsempfängern machen.

Aber der Arbeitsmarkt wird doch sicher grundlegend umgepflügt.

Das Argument, es drohe die ganz große Arbeitslosigkeit durch den technischen Wandel, hat man schon oft gehört, aber auf lange Sicht war es immer falsch. Wir finden doch kaum noch geeigneten Nachwuchs in Pflegeberufen, bei Lehrkräften, im Handwerk oder auch bei Ingenieuren.

Trotzdem wird die künstliche Intelligenz viele Berufe ersetzen. Könnte ein Roboter eines Tages Ihren Job übernehmen und als Richter im Gerichtssaal sitzen?

Es wäre vorstellbar, wenn wir es denn wollen.

Wollen wir es?

Ich glaube, wir sollten es nicht wollen. Wir brauchen an den Knotenpunkten unserer Gesellschaft menschliche Entscheidungskompetenz und auch Verantwortung. Sonst gefährdet sich die humane Gesellschaft selbst.

Die Steuerberater dürfen wir aber schon ersetzen?

Hier tendiere ich zu Aussageverweigerung. Ich möchte meiner Steuerberaterin noch in die Augen schauen können.